はじめに

ニューラルネットワークの複素数値化は一応成功したと言えるでしょう。さらに拡張するというのは自然な研究の流れでしょう。多くの人が思いつくのは四元数です。さらに多様な代数系を求めて、クリフォード代数などが試みられています。今回はモデル拡張の考え方を見る目的で MLP の四元数化を取り上げます。

単純な構成例

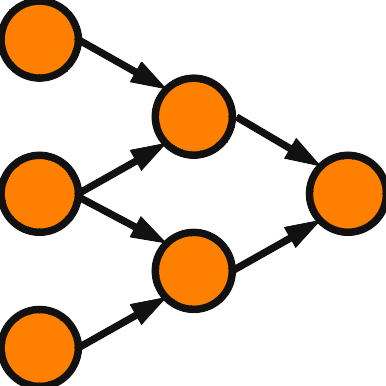

ニューラルネットワークの高次元化で何を決める必要があるかというと、ニューロンの入出力と入力和です。複素 MLP の場合を確認しましょう。ニューロンへの入力を直交座標系と極座標系の2通りで表して \( z = x+iy = r e^{i\theta} \) としましょう。複素 MLP の主な活性化関数2つを取り上げます。1つは split 型と呼ばれ、\( f(z) = \tanh(x) + i \tanh(y) \) と実部、虚部を独立に変換します。\( \tanh \) 以外の関数を使っても構いません。split 型は容易に四元数に拡張出来て、\( z= x_0+ix_1+jx_2+kx_3 \) に対して、\( f(z) = \tanh(x_0) + i \tanh(x_1) + j \tanh(x_2) + k \tanh(x_3) \) と定義します。研究事例は次の文献を参照してください。

T. Nitta: “A Quaternary Version of the Back-propagation Algorithm”, Proceedings of IEEE International Conference on Neural Networks, ICNN’95-Perth, Nov. 27-Dec. 1, Vol.5, pp.2753-2756 (1995).

T. Nitta: “An Extension of the Back-propagation Algorithm to Quaternions”, Proceedings of International Conference on Neural Information Processing, ICONIP’96-HongKong, Sep. 25-27, Vol.1, pp.247-250 (1996).

別の活性化関数としては位相型 \( f(z) = \tanh(r) e^{i\theta} \) があります。これも四元数化は容易ですが、研究事例はあまり知りません。

ニューロンへの入力和は \( \sum_l w_l z_l \) の形式になっています。これはそのまま四元数に拡張できますが、 四元数の積は非可換のため \( \sum_l w_l z_l \) と \( \sum_l z_l w_l \) は異なります。入力層ー中間層 と 中間層ー出力層 で積の順序を入れ替えた四元数 MLP も次の論文で提案されました。

M. Kobayashi, A. Nakajima: “Twisted Quaternary Neural Networks”, IEEJ Transactions on Electrical and Electronic Engineering, Vol.7, No.4, pp.397-401 (2012)

3次元の構成例

少し特徴のある構成例を解説しましょう。四元数の利用法の1つに3次元空間の回転作用があります。Arena がこれを反映した構成を提案しています。詳しくは次の書籍または Arena の論文を参照してください。

Neural Networks in Multidimensional Domains (Lecture Notes in Control and Information Sciences, 234) Paolo Arena著 Springer

四元数の実部を 0 にすることで、3成分になります。\( z=i x_1+j x_2+k x_3 \) と3次元の座標 \( (x_1,x_2,x_3) \) を対応させます。活性化関数は単純な構成例の場合と基本的に同じですが、実部がないので \( f(z) = i \tanh(x_1)+j \tanh(x_2)+k \tanh(x_3) \) となります。大きな違いは入力和にあり、\( \sum_l w_l \,z\, \overline{w_l} \) で与えられます。\( \overline{w_l} \) は \( w_l \) の共役です。\( w_l \,z\, \overline{w_l} \) は3次元空間内での回転と拡大縮小作用を実現します。

どこまで研究すればよいのか

本ブログは国際会議または論文誌の査読に通るレベルの研究を想定しています。どの程度の研究をすれば査読に通るのでしょうか。査読者の価値観にも大きく依存しますので、あくまでも個人的な戦略に過ぎないという点をご承知ください。上のように新しいモデルを考えるだけでも新規性はありますが、それだけでは査読者を納得させることは難しいと思います。それでも新規性はありますので、余裕のない国際会議では採択されるかもしれません。MLPの場合は学習アルゴリズムとしてバックプロパゲーション学習則を導出することが出来ます。バックプロパゲーションは単なる勾配降下法ですので、地道に計算すれば導出できます。学習則を実装すれば計算機シミュレーションを追加することが出来ます。それだけでは有用性が示せたわけではないですが、それなりに体裁が整いますのでレベルの低い国際会議なら採択される確率も上がるかもしれません。

単純な構成例で取り上げた新田先生の業績を見てみましょう。国際会議 ICONIP に採択されています。ICONIP はこの分野ではレベルが高い国際会議とされています。それは、提案モデルが従来のモデルより高速に学習できることをシミュレーションで示して、有用性を主張したことが理由だと思われます。Arena も論文が複数採択されていると思います。あまり憶えていませんが、ロボットのアームの制御に応用したと思います。こういった応用事例があると論文誌に採択されやすくなります。

研究課題

ここで研究課題を提供します。本記事を見てこの課題を研究される方にお願いですが、今後の発展のために研究成果は国際会議または英文論文誌で発表していただき、掲載誌を知らせていただけると幸いです。

私の主な研究テーマは連想記憶ですが、共同研究者と dual connection という方法を開発しました。dual connection に関しては次の文献があります。

T. Minemoto, T. Isokawa, M. Kobayashi, H. Nishimura, N. Matsui: “Pattern Retrieval by Quaternionic Associative Memory with Dual Connections”, International Conference on Neural Information Processing (ICONIP 2016), pp.317-325 (2016)

M. Kobayashi: “Quaternion-Valued Twin-Multistate Hopfield Neural Networks with Dual Connections”, IEEE Transactions on Neural Networks and Learning Systems, Vol.32, No.2, pp.892-899 (2021)

M. Kobayashi: “Storage Capacity of Quaternion-Valued Hopfield Neural Networks with Dual Connections”, Neural Computation, Vol.33, No.8, pp.2226-2240 (2021)

四元数の積は非可換のため入力和 \( \sum_l w_l z_l \) と \( \sum_l z_l w_l \) が異なることは既に述べました。この2つを同時に利用するために2つの四元数 \( w_l, w’_l \) を用意して、入力和を \( \sum_l ( w_l z_l + z_l w’_l ) \) とすることを提案しました。ニューロン間の結合を二重化した訳で、dual connection と名付けました。dual connection を MLP に導入した事例は知りませんので、導入すれば新規性はあると思います。ただし、連想記憶に導入した時は回転不変性対策という明確な目的がありましたが、MLP に適用した場合の利点は分かりません。